дёӯ科йҷўи®Ўз®—жүҖиҺ·еҘ–еҗҺ 第дәҢдёӘеҚҺдәә科еӯҰ家еӣўйҳҹеҶҚеӨәйҮ‘

еҸ‘зЁҝж—¶й—ҙпјҡ2021-08-09 20:37:00 жқҘжәҗпјҡ дёӯеӣҪйқ’е№ҙзҪ‘

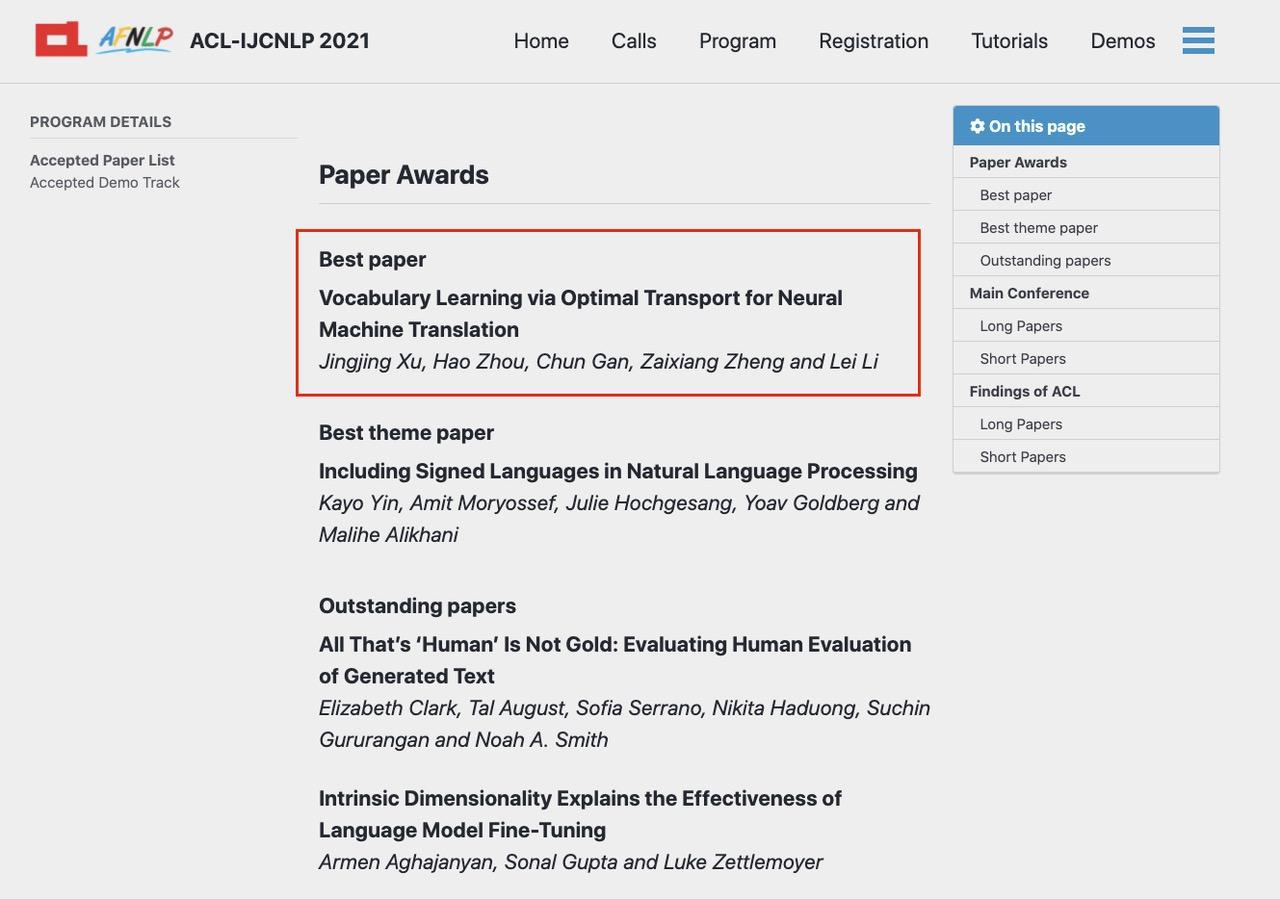

гҖҖгҖҖеҢ—дә¬ж—¶й—ҙ8жңҲ5ж—ҘпјҢдәәе·ҘжҷәиғҪйўҶеҹҹзҡ„вҖңеҘҘиҝҗдјҡвҖқACL 2021жӯЈејҸйўҒеҸ‘"жңҖдҪіи®әж–Ү"еҘ–йЎ№гҖӮеӯ—иҠӮи·іеҠЁзҡ„жңәеҷЁзҝ»иҜ‘жҠҖжңҜи®әж–ҮеңЁ3350зҜҮи®әж–ҮжҠ•зЁҝдёӯдёҖдёҫеӨәеҶ пјҢеҪ“йҖүд»Ҡе№ҙеәҰ"жңҖдҪіи®әж–Ү"гҖӮиҝҷжҳҜACLжҲҗз«Ӣ59е№ҙд»ҘжқҘпјҢеҚҺдәә科еӯҰ家еӣўйҳҹ第дәҢж¬Ўиөўеҫ—жңҖй«ҳеҘ–йЎ№пјҢжӯӨеүҚз”ұдёӯ科йҷўи®Ўз®—жүҖдё»еҜјзҡ„з ”з©¶йЎ№зӣ®жӣҫеңЁ2019е№ҙиҺ·иҜ„"жңҖдҪій•ҝи®әж–Ү"гҖӮ

гҖҖгҖҖиҮӘ然иҜӯиЁҖеӨ„зҗҶиў«иӘүдёә"дәәе·ҘжҷәиғҪзҡҮеҶ дёҠзҡ„жҳҺзҸ "пјҢеңЁжңәеҷЁзҝ»иҜ‘гҖҒжҗңзҙўгҖҒдҝЎжҒҜжөҒгҖҒиҫ“е…Ҙжі•зӯүйўҶеҹҹжңүзқҖе№ҝжіӣзҡ„еә”з”ЁгҖӮACLеӨ§дјҡз”ұеӣҪйҷ…и®Ўз®—иҜӯиЁҖеӯҰеҚҸдјҡдё»еҠһпјҢжҳҜиҮӘ然иҜӯиЁҖеӨ„зҗҶдёҺи®Ўз®—иҜӯиЁҖеӯҰйўҶеҹҹжңҖй«ҳзә§еҲ«зҡ„еӯҰжңҜдјҡи®®пјҢжҜҸе№ҙйғҪдјҡеҗёеј•е…ЁзҗғйЎ¶е°–й«ҳж Ўе’Ң科жҠҖе…¬еҸёзҡ„е…іжіЁдёҺеҸӮдёҺгҖӮ

гҖҖгҖҖжң¬еұҠACLеҸӮдёҺи§’йҖҗзҡ„жңәжһ„еҢ…жӢ¬ж–ҜеқҰзҰҸеӨ§еӯҰгҖҒеҚЎиҖҗеҹәжў…йҡҶеӨ§еӯҰгҖҒдәҡ马йҖҠгҖҒеҫ®иҪҜгҖҒи°·жӯҢзӯүпјҢи®әж–ҮеҪ•еҸ–зҺҮд»…дёә21.2%пјҢеҲӣиҝ‘дёүе№ҙжқҘж–°дҪҺгҖӮ

гҖҖгҖҖеӯҰжңҜжҲҗе°ұиҝӣжӯҘжҳҫи‘— дәәе·ҘжҷәиғҪйЎ¶дјҡз§ҖеҮәдёӯеӣҪеҠӣйҮҸ

гҖҖгҖҖиҝ‘е№ҙжқҘпјҢеҚҺдәәеӣўйҳҹеңЁиҮӘ然иҜӯиЁҖеӨ„зҗҶйўҶеҹҹз ”з©¶еҸ–еҫ—дәҶдёҫдё–зһ©зӣ®зҡ„жҲҗз»©пјҢиҝҮеҺ»ж•°е№ҙй—ҙжӣҫиҺ·еҫ—"жңҖдҪій•ҝи®әж–Ү"гҖҒ"жңҖдҪіеӯҰз”ҹи®әж–Ү"е’Ң"жқ°еҮәи®әж–Ү"еҘ–йЎ№гҖӮ

гҖҖгҖҖе®ҳж–№ж•°жҚ®жҳҫзӨәпјҢACL2021жқҘиҮӘдёӯеӣҪзҡ„и®әж–ҮжҠ•зЁҝж•°йҮҸе·Із»ҸеӨ§е№…и¶…и¶ҠзҫҺеӣҪпјҢ并йўҶе…Ҳе…¶д»–еӣҪ家дёҺең°еҢәпјҡе…ұжңү 1239 зҜҮи®әж–ҮжҠ•зЁҝжқҘиҮӘдёӯеӣҪеӨ§йҷҶпјҢе…¶дёӯ 251 зҜҮиў«жҺҘ收пјҢжҺҘ收зҺҮ 20.3%гҖӮ

гҖҖгҖҖд»Ҡе№ҙйҷӨдәҶеӯ—иҠӮи·іеҠЁиөўеҫ—жңҖй«ҳиҚЈиӘүпјҢеӨ§дјҡиҝҳиҜ„еҮәдәҶе…ӯзҜҮ"жқ°еҮәи®әж–Ү"пјҢйҰҷжёҜдёӯж–ҮеӨ§еӯҰдёҺи…ҫи®Ҝдәәе·ҘжҷәиғҪ Labзҡ„еҗҲдҪңи®әж–ҮжҲҗеҠҹе…ҘйҖүгҖӮ

гҖҖгҖҖеӣҫпјҡACL 2021е…¬еёғвҖңжңҖдҪіи®әж–ҮвҖқиҜ„йҖүз»“жһң

гҖҖгҖҖзәөи§Ӯиҝ‘еҚҒе№ҙдәәе·ҘжҷәиғҪйўҶеҹҹеҗ„зұ»йЎ¶зә§еӯҰжңҜдјҡи®®зҡ„з»ҹи®Ўж•°жҚ®пјҢеҚҺдәә科еӯҰ家еҸ–еҫ—зҡ„еӯҰжңҜжҲҗз»©еҸҜд»Ҙз”ЁвҖңеҚҒе№ҙзЈЁдёҖеү‘вҖқжқҘеҪўе®№гҖӮжӯӨеүҚпјҢеҗ„зұ»дәәе·ҘжҷәиғҪйЎ¶дјҡдёҖзӣҙз”ұзҫҺеӣҪзҡ„科жҠҖдјҒдёҡвҖңйңёеұҸвҖқпјҢе…¶дёӯпјҢи°·жӯҢзҡ„и®әж–ҮеҪ•еҸ–ж•°йҮҸйҒҘйҒҘйўҶе…ҲпјҢеҫ®иҪҜдҪҚеұ…第дәҢгҖӮ

гҖҖгҖҖз”ұдәҺиө·жӯҘзӣёеҜ№иҫғжҷҡпјҢдёӯеӣҪеӣўйҳҹж—©жңҹеңЁдәәе·ҘжҷәиғҪйЎ¶дјҡзҡ„еЈ°йҮҸеҜҘеҜҘпјҢи®әж–Үд№ҹдё»иҰҒжқҘиҮӘеӯҰжңҜжңәжһ„гҖӮжҚ®е®ҳж–№ж•°жҚ®з»ҹи®ЎпјҢжё…еҚҺеӨ§еӯҰе’ҢеҢ—дә¬еӨ§еӯҰпјҢжҳҜдёӯеӣҪиҝӣе…Ҙе…Ёзҗғеҗ„жңәжһ„и®әж–ҮеҸ‘иЎЁжҺ’иЎҢжҰңеүҚеҚҒеҪ“дёӯд»…жңүзҡ„дёӨжүҖй«ҳж ЎпјҢдёӯеӣҪ科еӯҰйҷўгҖҒдёӯеӣҪ科еӯҰйҷўеӨ§еӯҰгҖҒеҚ—дә¬еӨ§еӯҰзҡ„жҠ•зЁҝж•°йҮҸжҺ’еҗҚзҙ§йҡҸе…¶еҗҺгҖӮ

гҖҖгҖҖиҝ‘е№ҙжқҘпјҢйҡҸзқҖеӣҪ家е°Ҷдәәе·ҘжҷәиғҪжҠҖжңҜдёҠеҚҮдёәжҲҳз•ҘжҖ§зҡ„вҖң硬科жҠҖвҖқпјҢи¶ҠжқҘи¶ҠеӨҡзҡ„дјҒдёҡжӯЈеҠ еӨ§з ”еҸ‘еҠӣеәҰпјҢйҖҗжёҗеңЁд»ҺвҖңиҫ…еҠ©и§’иүІвҖқиҝӣеҢ–дёәдёӯеқҡеҠӣйҮҸгҖӮи…ҫи®ҜгҖҒйҳҝйҮҢе·ҙе·ҙгҖҒеҚҺдёәеҲҶеҲ«жҲҗз«ӢдәҶз§‘з ”жҖ§зҡ„е®һйӘҢе®ӨпјҢеҸ‘иЎЁдәҶеӨ§йҮҸзҡ„з§‘з ”и®әж–ҮгҖӮжӯӨж¬ЎпјҢеӯ—иҠӮи·іеҠЁзҡ„жңҖдҪіи®әж–Үд№ҹиў«иҜ„е®ЎиҖ…иҜ„и®әдёәвҖңжғіжі•йқһеёёеҲӣж–°пјҢдё”е·ҘдҪңжһҒдёәз»ҶиҮҙйҖҸеҪ»гҖӮиҝҷжҳҜд»ҘеҫҖдёӯеӣҪеӨ§йҷҶеӯҰиҖ…жүҖеҫҲе°‘иғҪеӨҹеҒҡеҲ°зҡ„зЁӢеәҰгҖӮвҖқ

гҖҖгҖҖдә§еӯҰз•Ңзҡ„е…ұеҗҢеҠӘеҠӣд№ӢдёӢпјҢеҚҺдәә科еӯҰ家дёҚд»…еңЁйЎ¶зә§еӯҰжңҜдјҡи®®дёҠеҸ‘еҮәжӣҙеӨ§зҡ„еЈ°йҮҸпјҢд№ҹжҺҢжҸЎдәҶжӣҙеӨҡиҜқиҜӯжқғгҖӮеңЁACL2021дёҠпјҢдёӯ科йҷўиҮӘеҠЁеҢ–жүҖз ”з©¶е‘ҳе®—жҲҗеәҶжӢ…д»»дәҶдё»еёӯпјҢеҚҺзӣӣйЎҝеӨ§еӯҰзҡ„еӨҸйЈһж•ҷжҺҲ(Fei Xia)е’ҢйҰҷжёҜзҗҶе·ҘеӨ§еӯҰзҡ„жқҺж–ҮжҚ·(Wenjie Li)ж•ҷжҺҲдҪҚеҲ—зЁӢеәҸдё»еёӯгҖӮ

гҖҖгҖҖе®—жҲҗеәҶиЎЁзӨәпјҢеӣҪеҶ…и®әж–Үж•°йҮҸзҡ„еўһй•ҝжҳҜдәәе·ҘжҷәиғҪйўҶеҹҹиҝ‘е№ҙжқҘзҒ«зғӯпјҢд»ҘеҸҠж–°жҠҖжңҜеә”з”ЁеүҚжҷҜжүҖжҺЁеҠЁзҡ„з»“жһңгҖӮйҡҸзқҖиҮӘ然иҜӯиЁҖеӨ„зҗҶжҠҖжңҜзҡ„еҸ‘еұ•пјҢжңӘжқҘжҲ‘们жҲ–и®ёиғҪзңӢеҲ°жӣҙеӨҡжҠ•иә«иҝҷдёҖйўҶеҹҹзҡ„еӯҰиҖ…гҖӮ

гҖҖгҖҖиҠӮиғҪеҮҸжҺ’ еӯ—иҠӮи·іеҠЁжңҖдҪіи®әж–Үз ”з©¶йЎ№зӣ®е·ІејҖжәҗ

гҖҖгҖҖеӯ—иҠӮи·іеҠЁзҡ„иҺ·еҘ–и®әж–ҮжҸҗеҮәдёҖз§Қж–°зҡ„иҜҚиЎЁеӯҰд№ ж–№жЎҲVOLTпјҢиҜҘж–№жЎҲдёҚд»…еңЁеӨҡз§Қзҝ»иҜ‘д»»еҠЎдёҠеҸ–еҫ—еҮәиүІзҡ„ж•ҲжһңпјҢеңЁйҷҚдҪҺзўіжҺ’ж”ҫгҖҒиҠӮиғҪзҺҜдҝқж–№йқўд№ҹжңүзқҖжҳҫи‘—дјҳеҠҝгҖӮе®һйӘҢж•°жҚ®жҳҫзӨәпјҢдҪҝз”ЁVOLTж–№жЎҲеҸҜиҠӮзңҒ92%зҡ„з®—еҠӣпјҢжңүж•ҲйҷҚдҪҺиғҪиҖ—гҖӮVOLTз ”з©¶йЎ№зӣ®зҺ°е·Іеҗ‘е…ЁзҗғејҖеҸ‘иҖ…ејҖжәҗгҖӮ

гҖҖгҖҖе…·дҪ“жқҘиҜҙпјҢиҜҚиЎЁжҳҜжүҖжңүиҮӘ然иҜӯиЁҖеӨ„зҗҶд»»еҠЎйғҪдјҡдҪҝз”Ёзҡ„еҹәзЎҖ组件пјҢе…¶дҪңз”Ёе°ұеғҸдәәзұ»жҹҘеӯ—е…ёзҡ„зҙўеј•гҖӮз ”з©¶дәәе‘ҳеҲӣж–°ең°жҠҠз»ҸжөҺеӯҰе’Ңж•°еӯҰзҡ„зҹҘиҜҶиҝҗз”ЁеҲ°иҜҚиЎЁдёӯпјҡйҰ–е…Ҳз”ЁвҖңиҫ№йҷ…收зӣҠвҖқе®ҡд№үдәҶиҜҚиЎЁиҙЁйҮҸзҡ„иҜ„д»·жҢҮж ҮпјҢ然еҗҺд»ҘвҖңжңҖдјҳиҝҗиҫ“вҖқзҡ„ж•°еӯҰж–№жі•и§ЈеҶіжңҖдјҳиҜҚиЎЁзҡ„з”ҹжҲҗй—®йўҳпјҢд»ҺиҖҢй«ҳиҙЁй«ҳж•Ҳең°е®ҢжҲҗеӨҡз§Қзҝ»иҜ‘д»»еҠЎгҖӮ

гҖҖгҖҖACLе®ҳж–№иҜ„е®Ўи®ӨдёәпјҢ"еӯ—иҠӮи·іеҠЁзҡ„VOLTж–№жЎҲеҜ№жңәеҷЁзҝ»иҜ‘дёӯдёҖдёӘйҮҚиҰҒй—®йўҳжҸҗеҮәдәҶжңүж•Ҳдё”ж–°йў–зҡ„и§ЈеҶіж–№жЎҲпјҢиғҪжҳҫи‘—еҮҸе°‘иҜҚиЎЁзҡ„еӯҰд№ е’Ңжҗңзҙўж—¶й—ҙпјҢзӣёдҝЎе…¶дёҚд»…дјҡеңЁз ”究з•Ңдә§з”ҹйҮҚиҰҒеҪұе“ҚпјҢеңЁе·Ҙдёҡеә”з”Ёж–№йқўд№ҹжңүзқҖе·ЁеӨ§жҪңеҠӣ"гҖӮ

гҖҖгҖҖиҮӘ2017е№ҙе·ҘдҝЎйғЁеҸ‘еёғгҖҠдҝғиҝӣж–°дёҖд»Јдәәе·ҘжҷәиғҪдә§дёҡеҸ‘еұ•дёүе№ҙиЎҢеҠЁи®ЎеҲ’(2018-2020е№ҙ)гҖӢпјҢиҮӘ然иҜӯиЁҖеӨ„зҗҶе°ұиў«еҲ—дёәжҲ‘еӣҪдәәе·ҘжҷәиғҪеә”з”Ёзҡ„йҮҚиҰҒж–№еҗ‘гҖӮжҲ‘еӣҪвҖңеҚҒеӣӣдә”вҖқ规еҲ’зәІиҰҒд№ҹжҸҗеҮәпјҢе°ҶйҖҡиҝҮдёҖжү№е…·жңүеүҚзһ»жҖ§гҖҒжҲҳз•ҘжҖ§зҡ„еӣҪ家йҮҚеӨ§з§‘жҠҖйЎ№зӣ®пјҢеёҰеҠЁдә§дёҡз•ҢйҖҗжӯҘзӘҒз ҙеүҚжІҝеҹәзЎҖзҗҶи®әе’Ңз®—жі•пјҢз ”еҸ‘дё“з”ЁиҠҜзүҮпјҢжһ„е»әж·ұеәҰеӯҰд№ жЎҶжһ¶зӯүејҖжәҗз®—жі•е№іеҸ°пјҢ并еңЁеӯҰд№ жҺЁзҗҶеҶізӯ–гҖҒеӣҫеғҸеӣҫеҪўгҖҒиҜӯйҹіи§Ҷйў‘гҖҒиҮӘ然иҜӯиЁҖиҜҶеҲ«еӨ„зҗҶзӯүйўҶеҹҹеҲӣж–°дёҺиҝӯд»Јеә”з”ЁгҖӮ

гҖҖгҖҖжҚ®жӮүпјҢжңҖдҪіи®әж–Үз ”з©¶жҲҗжһңе°ҶеңЁеӯ—иҠӮи·іеҠЁзҡ„зҒ«еұұзҝ»иҜ‘дёҡеҠЎдёӯйҖҗжӯҘиҗҪең°пјҢдёәйЈһд№ҰгҖҒд»Ҡж—ҘеӨҙжқЎзӯүдә§е“Ғе’ҢзҒ«еұұеј•ж“Һзҡ„дјҒдёҡзә§е®ўжҲ·жҸҗдҫӣжңәеҷЁзҝ»иҜ‘ж”ҜжҢҒгҖӮ2021е№ҙд»ҘжқҘпјҢзҒ«еұұзҝ»иҜ‘е®һзҺ°еӨҡйЎ№йҮҚиҰҒжҠҖжңҜзӘҒз ҙпјҢз ”еҸ‘еҮәж”ҜжҢҒ150дёӘиҜӯз§Қдә’иҜ‘зҡ„еӨ§и§„жЁЎзҝ»иҜ‘жЁЎеһӢmRASP2пјҢ并еҜ№еӨ–ејҖжәҗдәҶеҪ“еүҚдёҡз•ҢжңҖеҝ«зҡ„жҺЁзҗҶе’Ңи®ӯз»ғеј•ж“ҺLightSeq2.0пјҢд»ҘеҸҠз«ҜеҲ°з«ҜиҜӯйҹізҝ»иҜ‘е·Ҙе…·еҢ…NeurSTпјҢиҺ·еҫ—ејҖжәҗзӨҫеҢәзҡ„е№ҝжіӣеҘҪиҜ„гҖӮ

-

вҖңи№ӯзғӯеәҰвҖқзҡ„дәәпјҢеҲ«еҶҚж¶Ҳиҙ№е…Ёзәўе©ө

еҰӮжӯӨз§Қз§ҚпјҢиҷҪ然еӨҡе°‘дјҡз»ҷе…Ёзәўе©өзҡ„家дәәеёҰжқҘдёҖдәӣеҺӢеҠӣпјҢдҪҶжҖ»дҪ“иҖҢиЁҖпјҢеҸҚжҳ зҡ„д»ҚжҳҜзӨҫдјҡеҜ№дјҳз§ҖиҝҗеҠЁе‘ҳ...

2021-08-09 20:18:00 -

еӣҪдјҒи‘ЈдәӢй•ҝпјҢиҝһ7560е…ғзҡ„йЈҹе®ҝиҙ№йғҪиҰҒиҙӘ

8жңҲ9ж—ҘпјҢгҖҠдёӯеӣҪзәӘжЈҖзӣ‘еҜҹжҠҘгҖӢеӨҙзүҲеҲҠеҸ‘дәҶдёҖзҜҮйўҳдёәгҖҠдёӢеұһеҚ•дҪҚдёҚжҳҜвҖңз§ҒдәәйўҶең°вҖқгҖӢзҡ„дё“йўҳжҠҘйҒ“гҖӮеңЁ...

2021-08-09 20:06:00 -

вҖңйҘӯеңҲж–ҮеҢ–вҖқе·ІжҲҗжІүз–ҙз—јз–ҫпјҢеҸҳиҙЁеңҹеЈӨдҪ•ж—¶еӣһеҪ’жӯЈеёёпјҹ

жңҖиҝ‘еҗ„еӨ§зҪ‘з»ңе№іеҸ°пјҢйғҪеҸ‘еёғдәҶж•ҙжІ»вҖңйҘӯеңҲвҖқд№ұиұЎе…¬е‘ҠпјҢйҖҡиҝҮжё…зҗҶиҙҹйқўжңүе®ідҝЎжҒҜгҖҒеӨ„зҪ®иҝқ规иҙҰеҸ·гҖҒе…і...

2021-08-09 19:45:00 -

еҝғзҗҶ专家и°ҲиҝҪжҳҹпјҡ йҒҝе…Қиў«вҖңйҘӯеңҲжҖқз»ҙвҖқиЈ№жҢҹпјҢеҖЎеҜјз§ҜжһҒзҫҺеҘҪзҡ„д»·еҖји§Ӯ

ж—ҘеүҚпјҢиүәдәәеҗҙдәҰеҮЎеӣ ж¶үе«ҢејәеҘёиў«дҫқжі•еҲ‘жӢҳгҖӮжҳҺжҳҹж— и§Ҷжі•еҫӢеә•зәҝпјҢеә”еҪ“еҸ—еҲ°жі•еҫӢеҲ¶иЈҒгҖӮ然иҖҢпјҢд№ӢеҗҺе…¶...

2021-08-09 19:45:00 -

14з§’еҚіеҸҜж„ҹжҹ“пјҢеҫ·е°”еЎ”жҜ’ж ӘеЁҒиғҒжңүеӨҡеӨ§пјҹ

зӣ®еүҚпјҢж–°еҶ з—…жҜ’еҸҳејӮжҜ’ж Әеҫ·е°”еЎ”е·Із»Ҹдј ж’ӯиҮідё–з•ҢеӨҡдёӘеӣҪ家е’Ңең°еҢәпјҢжҲ‘еӣҪзҡ„е№ҝе·һгҖҒж·ұеңігҖҒдёңиҺһгҖҒз‘һдёҪ...

2021-08-09 19:35:00 -

еҢ—дә¬иҝҷдәӣеңәжүҖеҚ•дҪҚз–«жғ…йҳІжҺ§дёҚеҲ°дҪҚиў«зӮ№еҗҚ

иҮӘ7жңҲ29ж—Ҙд»ҘжқҘпјҢе…ұеҸ‘еҮәй—®йўҳйҖҡжҠҘ77ж¬ЎпјҢж¶үеҸҠеёӮеңәдё»дҪ“351家гҖӮе…¶дёӯпјҢжңқйҳіеҢәзӣӣеҚҺе®Ҹжһ—зІ®жІ№жү№еҸ‘еёӮеңә...

2021-08-09 17:08:00 -

ж–°еҚҺзӨҫи°ғжҹҘвҖңйҘӯеңҲвҖқйӣҶиө„зҡ„йҡҗи”ҪвҖңжҲҳзәҝвҖқпјҡиҜқйўҳйҷ„вҖңжү“жҰңвҖқй“ҫжҺҘ йӣҶиө„йҳө

6жңҲ15ж—Ҙиө·пјҢдёӯеӨ®зҪ‘дҝЎеҠһеңЁе…ЁеӣҪиҢғеӣҙеҶ…ејҖеұ•дёәжңҹ2дёӘжңҲзҡ„вҖңжё…жң—вҖҳйҘӯеңҲвҖҷд№ұиұЎж•ҙжІ»вҖқдё“йЎ№иЎҢеҠЁгҖӮи®°иҖ…...

2021-08-09 16:26:00 -

вҖңйңҖиҰҒз•ҷж„ҸвҖқзҡ„еҸҳејӮжҜ’ж ӘжӢүе§Ҷиҫҫпјҡ专家称世з•Ңе°ҡжңӘи®ӨиҜҶе…¶еҚұйҷ©жҖ§

иҝҷдёҖжңҖж—©еңЁз§ҳйІҒеҸ‘зҺ°зҡ„ж–°еҶ еҸҳејӮжҜ’ж Әзӣ®еүҚе·ІеңЁеҚ—зҫҺеӨҡеӣҪе№ҝжіӣдј ж’ӯпјҢ并жӯЈеҗ‘欧жҙІжү©ж•ЈгҖӮеңЁиҝҮеҺ»4е‘ЁеҶ…пјҢ...

2021-08-09 16:22:00 -

еҸ°еӘ’жү№зҫҺеҶӣе”®и®©еҸ°еҶҚеҪ“вҖңеҶӨеӨ§еӨҙвҖқ

еҸӮиҖғж¶ҲжҒҜзҪ‘8жңҲ9ж—ҘжҠҘйҒ“еҸ°ж№ҫдёӯж—¶ж–°й—»зҪ‘8жңҲ7ж—ҘеҸ‘иЎЁйўҳдёәгҖҠд№°иҮӘиЎҢзӮ®еҶҚеҪ“еҶӨеӨ§еӨҙгҖӢзҡ„ж–Үз« пјҢдҪңиҖ…жҳҜи°ӯ...

2021-08-09 16:21:00 -

зҰҸеҘҮпјҡиӢҘжҺҘз§ҚзҺҮдёҚжҸҗй«ҳ дё–з•ҢжҲ–еҮәзҺ°жӣҙеҚұйҷ©ж–°еҶ еҸҳз§Қ

жҚ®зҫҺеӣҪеӘ’дҪ“8ж—ҘжҠҘйҒ“пјҢзҫҺеӣҪдј жҹ“病专家е®үдёңе°јВ·зҰҸеҘҮиҝ‘ж—ҘиЎЁзӨәпјҢеҰӮжһңеҗ„еӣҪдәәеҸЈдёҚиғҪе®һзҺ°е®Ңе…ЁжҺҘз§ҚпјҢйӮЈ...

2021-08-09 16:19:00 -

жҺЁиҝҹејҖеӯҰпјҒеҸҲжңүй«ҳж ЎеҸ‘йҖҡзҹҘ

иҝ‘ж—ҘпјҢеҸҲжңүеӨҡжүҖй«ҳж Ўе®ЈеёғпјҢи°ғж•ҙејҖеӯҰж—¶й—ҙгҖӮ8жңҲ9ж—ҘдёӯеҚҲпјҢ@е“Ҳе°”ж»Ёе·ҘдёҡеӨ§еӯҰеҸ‘еёғж¶ҲжҒҜпјҢеӣ иҝ‘жңҹж–°еҶ иӮә...

2021-08-09 16:17:00 -

еҸ°еӘ’пјҡзҫҺеӣҪзӣҹеҸӢдёҚж„ҝеңЁеҜ№еҸ°еҶӣе”®й—®йўҳдёҠеҫ—зҪӘдёӯеӣҪ

жҚ®еҸ°ж№ҫдёңжЈ®ж–°й—»зҪ‘8жңҲ6ж—ҘжҠҘйҒ“пјҢзҫҺеӣҪд»Һзү№жң—жҷ®ж—¶д»ЈеҲ°жӢңзҷ»дёҠеҸ°пјҢеүҚеҗҺжү№еҮҶ12йЎ№еҜ№еҸ°еҶӣе”®жЎҲпјҢеӨҡж¬Ўеј•...

2021-08-09 16:16:00 -

е®Ғ波银дҝқзӣ‘еұҖиҝһејҖ8еј зҪҡеҚ• е·Ҙе•Ҷ银иЎҢгҖҒе®Ғ波银иЎҢзӯүиў«зҪҡ

8жңҲ6ж—ҘпјҢе®Ғ波银дҝқзӣ‘еұҖжҺҘиҝһејҖеҮә7еј зҪҡеҚ•пјҢе·Ҙе•Ҷ银иЎҢгҖҒе®Ғ波银иЎҢгҖҒе®Ғ波甬еҹҺеҶңе•Ҷ银иЎҢеқҮйўҶеҲ°зҪҡеҚ•гҖӮе…¶...

2021-08-09 15:55:00 -

еӨ§йӣҒеңЁз©әдёӯеҖ’йЈһ 专家пјҡе®ғеңЁзӮ«иҖҖ

ж‘„еҪұеёҲVincent CornelissenеңЁиҚ·е…°йҳҝзәіе§ҶеҸ‘зҺ°дёҖеҸӘж·ұзҒ°иүІзҡ„еӨ§йӣҒеңЁз©әдёӯеҖ’йЈһпјҢе®ғзҡ„иә«дҪ“зҝ»иҪ¬иҝҮжқҘпјҢ...

2021-08-09 15:39:00 -

жҜҸе‘Ё3ж¬ЎпјҒзӢ—зӢ—й…·зҲұе’Ңдё»дәәдёҖиө·ж»‘йӣӘ

жҚ®иӢұеӣҪгҖҠйғҪеёӮжҠҘгҖӢ8жңҲ8ж—ҘжҠҘйҒ“пјҢжңҖиҝ‘дёҖеҸӘй…·зҲұеңЁйӣӘеқЎдёҠж»‘йӣӘзҡ„зӢ—зӢ—еҗёеј•дәҶдәә们зҡ„жіЁж„ҸгҖӮ

2021-08-09 15:39:00 -

иӢұеӣҪеҘіеӯҗйҒӣзӢ—ж—¶еҸ‘зҺ°зЁҖжңүй»„иңӮ 100е№ҙжқҘеҸӘеҮәзҺ°иҝҮ3ж¬Ў

жҚ®иӢұеӣҪгҖҠй•ңжҠҘгҖӢ8жңҲ7ж—ҘжҠҘйҒ“пјҢиӢұеӣҪдјҚж–Ҝзү№дёҖеҗҚеҘіеӯҗеңЁйҒӣзӢ—ж—¶жӢҚж‘„еҲ°дәҶдёҖеҸӘйқһеёёзЁҖжңүзҡ„й»„иңӮпјҢиҝҮеҺ»100...

2021-08-09 15:39:00 -

жғҠеҝғеҠЁйӯ„зҡ„дёҖеҲ»пјҡжҪңж°ҙе‘ҳеңЁжө·дёӯдёҺйІЁйұјзӣёйҒҮ

жҚ®иӢұеӣҪгҖҠй•ңжҠҘгҖӢ8жңҲ8ж—ҘжҠҘйҒ“пјҢдёҖдҪҚеҗҚеҸ«Martin Yellandзҡ„жҪңж°ҙе‘ҳеңЁиӢұеӣҪзҡ„еә·жІғе°”жө·еІёеәҰеҒҮжҪңж°ҙж—¶пјҢ...

2021-08-09 15:38:00 -

дёӯеӣҪеҘҘиҝҗеҒҘе„ҝе–ҠиҜқиҲӘеӨ©иӢұйӣ„пјҡи§ӮеҗҺж„ҹ已收еҲ°пјҒж„ҹи°ўж”ҜжҢҒпјҢзӣје№іе®үеҮҜж—ӢпјҒ

йҡҸзқҖеҘҘиҝҗзҡ„жёҗе…Ҙе°ҫеЈ°пјҢвҖңеӨӘз©әеҮәе·®дёүдәәз»„вҖқвҖ”вҖ”иҒӮжө·иғңгҖҒеҲҳдјҜжҳҺгҖҒжұӨжҙӘжіўеңЁеӨӘз©әз”ҹжҙ»д№ҹе·ІиҝҮеҚҠпјҢеҪ“...

2021-08-09 15:34:00 -

гҖҠд№Ўжқ‘зҲұжғ…гҖӢи°ўеӨ§и„ҡжү®жј”иҖ…дәҺжңҲд»ҷеӣ иҪҰзҘёеҺ»дё–пјҢз»Ҳе№ҙ50еІҒ

з”өи§Ҷеү§гҖҠд№Ўжқ‘зҲұжғ…гҖӢдёӯвҖңи°ўеӨ§и„ҡвҖқжү®жј”иҖ…дәҺжңҲд»ҷеҘіеЈ«дәҺ8жңҲ9ж—ҘеңЁеҶ…и’ҷеҸӨйҳҝжӢүе–„еҸ‘з”ҹиҪҰзҘёдёҚе№ёеҺ»дё–гҖӮ

2021-08-09 14:35:00 -

жұҹиӢҸжү¬е·һз®ЎжҺ§еҶҚеҚҮзә§ е°ҒжҺ§з®ЎзҗҶе°ҸеҢәжҜҸжҲ·жҜҸ3иҮі5еӨ©йҷҗдёҖдәәеӨ–еҮә

9ж—ҘпјҢжұҹиӢҸзңҒжү¬е·һеёӮз–«жғ…йҳІжҺ§ж–°й—»еҸ‘еёғдјҡйҖҡжҠҘпјҢ8жңҲ8ж—Ҙ0-24ж—¶пјҢжү¬е·һж–°еўһжң¬еңҹзЎ®иҜҠз—…дҫӢ38дҫӢпјҢжң¬иҪ®з–«...

2021-08-09 13:53:00 -

еЎ”еҲ©зҸӯеҜ№зҫҺеӣҪеҸ‘еҮәиӯҰе‘Ҡ

з»јеҗҲжі•ж–°зӨҫзӯүеӨ–з”өж¶ҲжҒҜпјҢеЎ”еҲ©зҸӯж”ҝжІ»еҠһе…¬е®ӨеҸ‘иЁҖдәәеҪ“ең°ж—¶й—ҙ8ж—ҘеҜ№еҚҠеІӣз”өи§ҶеҸ°иҜҙпјҢиҜҘз»„з»ҮдёҺйҳҝеҜҢжұ—ж”ҝ...

2021-08-09 13:50:00 -

вҖңйҳҝйҮҢеҘіе‘ҳе·Ҙиў«дҫөе®івҖқж¶үдәӢз”·еӯҗи·іж§Ҫпјҹеӯ—иҠӮи·іеҠЁпјҡз»ҲжӯўжӢӣиҒҳжөҒзЁӢ

иҝ‘ж—ҘпјҢйҳҝйҮҢе·ҙе·ҙвҖңеҘіе‘ҳе·Ҙиў«дҫөзҠҜвҖқдәӢ件引еҸ‘зӨҫдјҡе…іжіЁгҖӮ8жңҲ9ж—ҘеҚҲй—ҙпјҢдёҖеҲҷйўҳдёәвҖңжӣІдёҖеҺ»еӯ—иҠӮи·іеҠЁйқў...

2021-08-09 13:46:00 -

еӨ–еӘ’пјҡйҮ‘жӯЈжҒ©еҸ·д»ӨеҶӣйҳҹжҠ•е…Ҙж•‘зҒҫжҲҳж–—

жҚ®жңқдёӯзӨҫе№іеЈӨ8жңҲ8ж—ҘжҠҘйҒ“пјҢжңқйІңеҠіеҠЁе…ҡдёӯеӨ®еҶӣдәӢ委е‘ҳдјҡ5ж—Ҙе°ұжҡҙйӣЁжҙӘж¶қж•‘зҒҫйҮҚе»әе·ҘдҪңдёӢиҫҫдәҶзҙ§жҖҘеҸ¬ејҖ...

2021-08-09 13:47:00 -

еј е®¶з•ҢеёӮж–°еўһ10дҫӢжң¬еңҹзЎ®иҜҠз—…дҫӢ жҙ»еҠЁиҪЁиҝ№е…¬еёғ

8жңҲ8ж—Ҙ0-24ж—¶пјҢж№–еҚ—зңҒеј е®¶з•ҢеёӮж–°еўһ10дҫӢжң¬еңҹж–°еҶ иӮәзӮҺзЎ®иҜҠз—…дҫӢпјҢзҺ°е°Ҷе…¶жҙ»еҠЁиҪЁиҝ№е…¬еёғеҰӮдёӢпјҡдёҖгҖҒ...

2021-08-09 13:45:00 -

вҖңе№іи§ҶдёҖд»ЈвҖқзңӢеҘҘиҝҗпјҡдёәдҪ•еӨ–еӘ’ж„ҹеҸ№вҖңдёӯеӣҪдәәеҸҳдәҶвҖқпјҹ

иҝҷеұҠеҘҘиҝҗдјҡж— з–‘жҳҜзү№ж®Ҡзҡ„дёҖеұҠпјҢеҸ—з–«жғ…еҪұе“ҚпјҢиҝҗеҠЁе‘ҳзҡ„жҜ”иөӣ规еҲҷе’ҢеңЁеҘҘиҝҗжқ‘зҡ„з”ҹжҙ»йғҪдёҺеҫҖеёёжңүдәҶеҫҲ...

2021-08-09 13:44:00 -

йғ‘е·һе…¬еёғ6дҫӢж— з—ҮзҠ¶ж„ҹжҹ“иҖ…е’Ң3дҫӢзЎ®иҜҠз—…дҫӢзҡ„жҙ»еҠЁиҪЁиҝ№

жҚ®вҖңйғ‘е·һеҸ‘еёғвҖқеҫ®дҝЎе…¬дј—еҸ·еҸ‘еёғзҡ„ж¶ҲжҒҜпјҢйғ‘е·һеёӮж–°еҶ иӮәзӮҺз–«жғ…йҳІжҺ§йўҶеҜје°Ҹз»„еҠһе…¬е®ӨйҖҡжҠҘ6дҫӢж— з—ҮзҠ¶ж„ҹ...

2021-08-09 13:32:00 -

зҒҢй…’гҖҒзҢҘдәөгҖҒиҜҒжҚ®иў«жҜҒпјҹеҫӢеёҲи°ҲвҖңйҳҝйҮҢеҘіе‘ҳе·Ҙиў«дҫөе®івҖқ

зҪ‘дј вҖңйҳҝйҮҢеҘіе‘ҳе·Ҙиў«дҫөе®івҖқдёҖдәӢеңЁиҲҶи®әеңәдёҠжІёжІёжү¬жү¬гҖӮ8ж—ҘпјҢжөҺеҚ—иӯҰж–№йҖҡжҠҘз§°пјҢзӣ®еүҚжӯЈеңЁз§ҜжһҒи°ғжҹҘеҸ–...

2021-08-09 13:26:00 -

жү¬е·һйҖҡжҠҘдёҖиө·жЈҖжөӢзӮ№иҒҡйӣҶжҖ§з–«жғ…пјҡе·Іжңү25дәәж„ҹжҹ“еҗ«3дҪҚе·ҘдҪңдәәе‘ҳ

жҚ®вҖңжү¬е·һеҸ‘еёғвҖқеҫ®дҝЎе…¬дј—еҸ·8жңҲ8ж—ҘдёӢеҚҲж¶ҲжҒҜпјҢжү¬е·һеёӮзәӘ委зӣ‘委йҖҡжҠҘпјҢ7жңҲ29ж—ҘпјҢжү¬е·һе№ҝйҷөеҢәж№ҫеӨҙй•ҮиҒ”...

2021-08-09 13:07:00 -

жІіеҚ—пјҡеҚіж—Ҙиө·жҡӮеҒңи·ЁзңҒеӣўйҳҹж—…жёёеҸҠвҖңжңәзҘЁ+й…’еә—вҖқдёҡеҠЎ

жІіеҚ—зңҒж–ҮеҢ–е’Ңж—…жёёеҺ…жңҖж–°дёӢеҸ‘зҡ„гҖҠе…ідәҺз§ҜжһҒеә”еҜ№ж–°еҶ иӮәзӮҺз–«жғ…иҝӣдёҖжӯҘеҠ ејәи·ЁзңҒж—…жёёз®ЎзҗҶе·ҘдҪңзҡ„йҖҡзҹҘ...

2021-08-09 11:08:00 -

жІіеҚ—ејҖе°Ғж–°еўһзЎ®иҜҠз—…дҫӢдёәжӯӨеүҚж„ҹжҹ“иҖ…йӮ»еұ… дёҺйғ‘е·һеёӮе…ӯйҷўзӣёе…іиҒ”

2021е№ҙ8жңҲ8ж—ҘпјҢжІіеҚ—зңҒејҖе°ҒеёӮж–°еўһ1дҫӢж–°еҶ иӮәзӮҺзЎ®иҜҠз—…дҫӢпјҢжҳҜж¶үйғ‘е·һеёӮ第е…ӯдәәж°‘еҢ»йҷўе…іиҒ”дәәе‘ҳпјҢзі»е°ү...

2021-08-09 10:58:00 -

жұҹиӢҸеҚ—дә¬еҒҘеә·з ҒвҖңй»„иҪ¬з»ҝвҖқ йңҖиҰҒиҝҷдёӨдёӘжқЎд»¶

д»ҠеӨ©пјҲ8жңҲ9ж—ҘпјүдёҠеҚҲпјҢжұҹиӢҸзңҒеҚ—дә¬еёӮеҸ¬ејҖз–«жғ…йҳІжҺ§ж–°й—»еҸ‘еёғдјҡгҖӮеҚ—дә¬еёӮеҚ«еҒҘ委еүҜдё»д»»дёҒе°Ҹе№ід»Ӣз»Қпјҡ...

2021-08-09 10:56:00 -

жІіеҚ—ејҖе°Ғж–°еўһ1дҫӢж–°еҶ иӮәзӮҺзЎ®иҜҠз—…дҫӢ иҜҰжғ…е…¬еёғ

жҚ®ејҖе°ҒеёӮе§”е®Јдј йғЁеҫ®дҝЎе…¬дј—еҸ·ж¶ҲжҒҜпјҢејҖе°ҒеёӮж–°еҶ иӮәзӮҺз–«жғ…еҠһе…¬дјҡйҳІжҺ§жҢҮжҢҘйғЁеҠһе…¬е®Ө9ж—ҘеҸ‘еёғйҖҡжҠҘз§°пјҢ...

2021-08-09 10:56:00

дә¬е…¬зҪ‘е®үеӨҮ 11010102004843еҸ·

дә¬е…¬зҪ‘е®үеӨҮ 11010102004843еҸ·